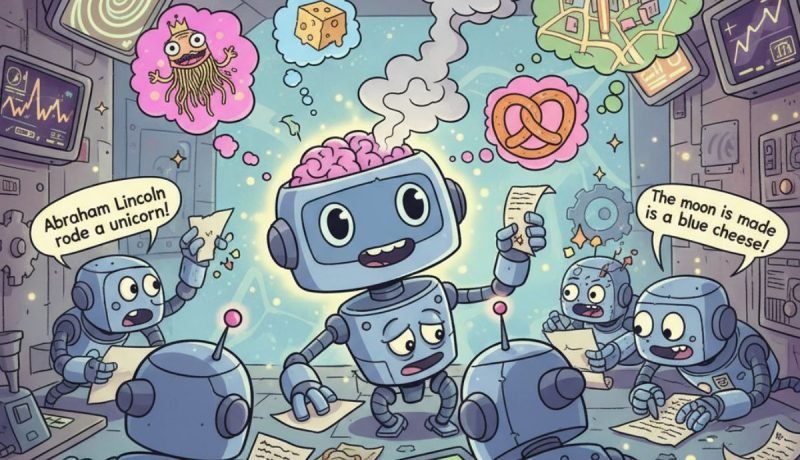

La inteligencia artificial, con sus asistentes conversacionales como ChatGPT o Gemini, ha transformado la forma en que muchos abordan sus tareas diarias, tanto en el ámbito profesional como personal. Sin embargo, estas herramientas de IA presentan un desafío significativo: las alucinaciones. Este fenómeno se manifiesta cuando la IA genera información que, aunque convincente y plausible, carece de veracidad. Si bien este error puede ser inofensivo en conversaciones casuales, se convierte en un riesgo considerable en áreas críticas como la medicina o el derecho.

Un estudio conjunto de OpenAI y el Georgia Institute of Technology ha arrojado luz sobre las causas de este comportamiento, revelando que los modelos de IA no alucinan por un diseño intencionado, sino porque sus sistemas de entrenamiento y evaluación los incentivan a ello. Curiosamente, este problema se agrava en los modelos avanzados, lo que implica que los usuarios de versiones de pago podrían recibir respuestas más propensas a la falsedad.

¿Por Qué la IA «Miente»? Factores Clave

La investigación sugiere que la raíz del problema no es una propensión intrínseca a la fantasía por parte de la IA, sino más bien una consecuencia de cómo se entrenan y evalúan. Los modelos son recompensados por adivinar en lugar de admitir su incertidumbre. Este análisis se desglosa en dos fases cruciales:

Fase de Entrenamiento: Presiones Estadísticas

En su nivel más fundamental, los modelos de IA aprenden a predecir la siguiente palabra en una secuencia, un proceso que involucra miles de millones de datos. Cuando la IA se encuentra con información muy específica, rara o sin un patrón claro (por ejemplo, el año de nacimiento exacto de un personaje histórico poco conocido), se enfrenta a un dilema. Al no disponer de datos suficientes para discernir la veracidad o un posible error, las presiones estadísticas la inclinan a generar una respuesta que suena correcta, aunque sea errónea.

👉 La IA no inventa maliciosamente, sino que comete un error de clasificación, un subproducto natural de su proceso de aprendizaje. Se asemeja a un estudiante que, al no conocer una respuesta precisa, se ve obligado a adivinar en un examen.

Fase de Evaluación: La «Epidemia» de los Benchmarks

El estudio señala que la forma en que se miden los modelos de lenguaje en la industria, a través de benchmarks (exámenes de referencia), es un factor determinante en la persistencia de las alucinaciones. Estos exámenes priorizan la precisión binaria: una respuesta es 100% correcta (1 punto) o 100% incorrecta (0 puntos), sin puntos intermedios.

- Si un modelo se enfrenta a una pregunta difícil y responde «No lo sé», su puntuación es cero.

- Si se arriesga con una respuesta plausible, tiene la posibilidad de acertar y obtener un punto.

Este incentivo perverso lleva a la IA a «aprender» que es mejor adivinar que abstenerse. El estudio lo describe como una «epidemia de penalizar la incertidumbre», que ha moldeado el comportamiento de la IA, fomentando la falta de fiabilidad.

Modelos Avanzados: ¿Más Inteligentes, Más Mentiroso?

Según los hallazgos del estudio, los modelos de IA más avanzados alucinan con mayor frecuencia.

- En un conjunto de datos de preguntas y respuestas sobre personas (PersonQA), un modelo avanzado de OpenAI inventó respuestas el 33% de las veces, duplicando la tasa de su versión anterior.

- El modelo más pequeño, o4-mini, obtuvo un resultado aún peor, con un 48% de alucinaciones.

Este dato es revelador, ya que estos mismos modelos mostraron mayores habilidades matemáticas. Esto sugiere que a medida que la IA mejora en ciertas tareas, también se la incentiva a ser más audaz y menos cautelosa, lo que conduce a la generación de más afirmaciones falsas pero convincentes.

La principal conclusión del estudio es que las alucinaciones no son un fallo insondable de la IA, sino una consecuencia lógica de un sistema que penaliza la honestidad. Desde Marketing4ecommerce, donde utilizamos ChatGPT de pago para diversas tareas, hemos observado esta tendencia. Hemos notado que, con el tiempo, los GPTs específicos que hemos creado se vuelven cada vez más imprecisos, alejándose de las directrices iniciales hasta el punto de que la mejor solución es eliminarlos y crear nuevos.

Cambiar las Reglas del Juego: Una Solución Necesaria

El estudio propone una solución que va más allá de la construcción de modelos más grandes y complejos. La clave no reside en la tecnología, sino en la filosofía de evaluación. Los investigadores argumentan que, en lugar de crear nuevos exámenes específicos para detectar alucinaciones, la industria debería modificar las reglas de los exámenes existentes.

La propuesta es cambiar la forma en que se califica a los modelos para recompensar la honestidad. Las nuevas métricas de evaluación deberían adoptar un sistema más sofisticado que el simple «todo o nada»:

- ❌ Penalizar errores seguros: Un modelo que proporciona una respuesta incorrecta con alta confianza debería ser penalizado, restándole puntos.

- ✅ Recompensar la incertidumbre: Un modelo que dice «no lo sé» cuando la respuesta es incierta debería recibir un crédito o, al menos, no ser penalizado con un cero.

Esta lógica es similar a la de algunos exámenes de opción múltiple, donde las respuestas incorrectas restan puntos, incentivando a los estudiantes a dejar la pregunta en blanco si no están seguros. Al implementar este cambio, la industria puede guiar el desarrollo de modelos de IA que no solo sean más precisos, sino también más confiables y honestos sobre sus propias limitaciones.

⚠️ Nuestro friendly consejo: Nunca confíes ciegamente en una IA. Siempre verifica la información generada, especialmente en contextos críticos.