Una reciente falla en el proceso de scraping de datos ha encendido las alarmas sobre la seguridad y eficiencia en la recopilación de información digital. Este incidente ha impulsado a desarrolladores y usuarios a reevaluar los métodos actuales de obtención de datos, subrayando la importancia crítica de la precisión y la confiabilidad en la extracción de información. En el epicentro de este desafío, se destaca la urgencia de contar con herramientas más robustas y eficaces que puedan gestionar vastos volúmenes de datos sin comprometer su integridad.

Factores Detrás del «Scrape Failed» y sus Repercusiones

La falla se atribuye a una confluencia de factores técnicos y de diseño que han provocado una cascada de errores durante el proceso de extracción. Las consecuencias han sido significativas:

- ⏰ Retrasos en proyectos que dependen crucialmente de estos datos.

- 💸 Pérdidas financieras considerables para las empresas afectadas.

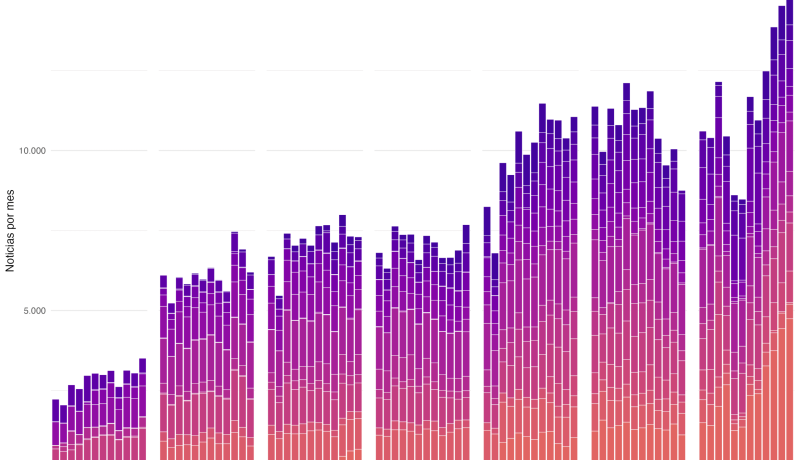

A medida que la dependencia del ecosistema digital y la información en línea continúa su ascenso, la búsqueda y adopción de soluciones más avanzadas se convierte en una prioridad ineludible.

Impacto en el Marketing Digital y el Ecommerce

En el ámbito del marketing digital y el ecommerce, la interrupción en la extracción de datos puede tener efectos devastadores. La capacidad de recopilar información de precios de la competencia, analizar tendencias de mercado o monitorear el sentimiento del consumidor se ve directamente afectada. Esto imposibilita a las empresas tomar decisiones estratégicas fundamentadas, impactando la agilidad y competitividad en un entorno digital en constante evolución. La optimización de campañas publicitarias y la personalización de la experiencia del usuario también dependen en gran medida de un flujo constante y fiable de datos.

Innovación en la Recopilación de Datos

Frente a este panorama, expertos en el campo están dedicando esfuerzos a desarrollar nuevas tecnologías que fortalezcan la fiabilidad de los procesos de scraping. Los focos de innovación incluyen:

- 🤖 Automatización inteligente para una extracción de datos más autónoma y eficiente.

- 🔄 Flexibilidad para adaptarse a la diversidad de fuentes de datos y estructuras cambiantes de sitios web.

Si bien el camino hacia la perfección es complejo, la innovación en este sector es fundamental para asegurar el futuro de la recopilación de datos en Internet, garantizando que las empresas puedan seguir extrayendo valor del vasto océano de información disponible en línea.